文章信息

- 曹君, 李爱莲, 解韶峰, 崔桂梅

- CAO Jun, LI Ailian, XIE Shaofeng, CUI Guimei

- 应用改进YOLOv5s的转炉下渣状态检测算法研究

- Research on the state detection algorithm of slag in converter based on improved YOLOv5s

- 中国测试, 2024, 50(7): 163-169

- CHINA MEASUREMENT & TEST, 2024, 50(7): 163-169

- http://dx.doi.org/10.11857/j.issn.1674-5124.2022080004

-

文章历史

- 收稿日期: 2022-08-01

- 收到修改稿日期: 2022-09-28

2. 内蒙古科技大学基建处,内蒙古 包头 014010

2. Department of Infrastructure, Inner Mongolia University of Science and Technology,Baotou 014010, China

“十四五”规划钢铁工业是建设现代化强国的重要支撑,是实现绿色低碳发展的重要领域。文献[1]阐述了转炉炼钢和电炉炼钢之间的优缺点,两者面向不同需求钢种的生产。转炉炼钢是炼钢流程重要的一环,通过吹氧与废钢、石灰石、铁矿石等冷却剂保证高温氧化环境,以白云石与石灰造渣剂控制铁水中C、Si、Mn、P、S、O的含量,达到出钢条件,为后续工序提供良好基础。然而出钢过程中会夹杂钢渣,文献[2]指出了钢渣的特性、作用以及存在的问题。及时的挡渣操作可以减少钢包中P、S等有害物质,降低钢水氧化程度,提升钢铁产品品质;同时降低石灰、铝添加剂等原材料的消耗,延长耐火炉衬等器械的使用寿命[3]。因此,研究下渣状态检测进而达到及时挡渣操作是有重大意义的。

人工目测法、电磁线圈检测法[4]和红外热像检测法[5] 是当前主流的下渣检测方法。人工目测法受限于人为主观因素,精确度低,实时性不理想,且对长时间处于现场环境下的人有一定的伤害性。电磁线圈检测法受限于线圈材料的使用寿命不稳定和维护成本较高,不适于长期使用。红外热成像检测法由于需对图像进行去噪、滤波等预处理,造成图像信息丢失,从而影响检测精确度[6]。文献[7-8]均通过钢水、钢渣红外热像下热辐射差异性,建立红外下渣图像检测系统,准确判断下渣点,为挡渣设备提供指导。

近年来,基于深度学习的目标检测方法得到众多学者青睐。文献[9]通过DenseNet融合CBAM加强对关键特征的提取,实现猪脸图像的准确分类。文献[10]基于一阶段目标检测方法SSD引入MobileNets形成轻量化网络,并结合CF目标跟踪方法,实现了无人艇的精准目标检测跟踪。文献[11]基于Faster R-CNN,采用ResNet101作为主干网络增强特征提取,引入递归金字塔进行特征融合,提高了模型的检测性能,但Faster R-CNN实时性较差。文献[12]对YOLOv5主干网络融入注意力机制,提高了模型检测精度。这些都对基于彩色下渣图像的出钢状态检测研究提供借鉴和理论支撑。

YOLOv5因其直接输入目标图像得到类别与位置信息,具有轻量、简单、实时性好、精度高等优点,被广泛应用于航天、交通等目标检测领域,但在转炉炼钢下渣状态检测方面尚未检索到相关应用。在包钢,一炉钢是45 min,流程为:炼钢准备工作、配料、装填、前中后期吹氧和加造渣剂、出钢和脱氧合金化,其中出钢下渣状态持续时间短,结合CCU-TSD-11红外下渣检测单元进行下渣检测,精度与实时性较差。而YOLOv5能很好地满足实时性检测,因此,本文拟基于包钢现场基础自动化条件具备的彩色下渣图像,在YOLOv5主干网络添加CBAM注意力模块、颈部层引入BiFPN、预测层使用EIoU Loss函数进行改进,提出了改进算法YOLOv5s_CBE(CBAM+BiFPN+EIoU),旨在保持算法快速性的同时,提高检测精度。

1 YOLOv5s模型基本原理YOLO算法经过不断更新迭代已经发展出YOLOv1[13]、YOLOv2[14]、YOLOv3[15]、YOLOv4[16]、YOLOv5等版本。相比之前的YOLO算法,YOLOv5s检测速度更快,精度更高,权重体量更小,结构如图1所示。

|

| 图 1 YOLOv5s网络模型结构 |

YOLOv5s主要有4部分,分别是输入端、主干网络、颈部层、预测层。输入端运用Mosaic数据增强丰富了数据集信息,自适应锚框设计自动生成合适的先验框,自适应图片缩放减少了图像冗余信息、计算量。主干网络主要由卷积模块、CSPDarkNet53和SPPF模块组成,实现输入图像的特征提取。颈部层主要由特征金字塔网络(FPN)[17]和路径聚合网络(PAN)[18]组成,进行不同尺度下的信息交互,融合浅层位置信息与深层类别信息,达到特征信息利用最大化。预测层由CIoU Loss函数和预测框函数组成,进行信息损失计算,生成预测框,输出大、中、小3种不同目标结果。

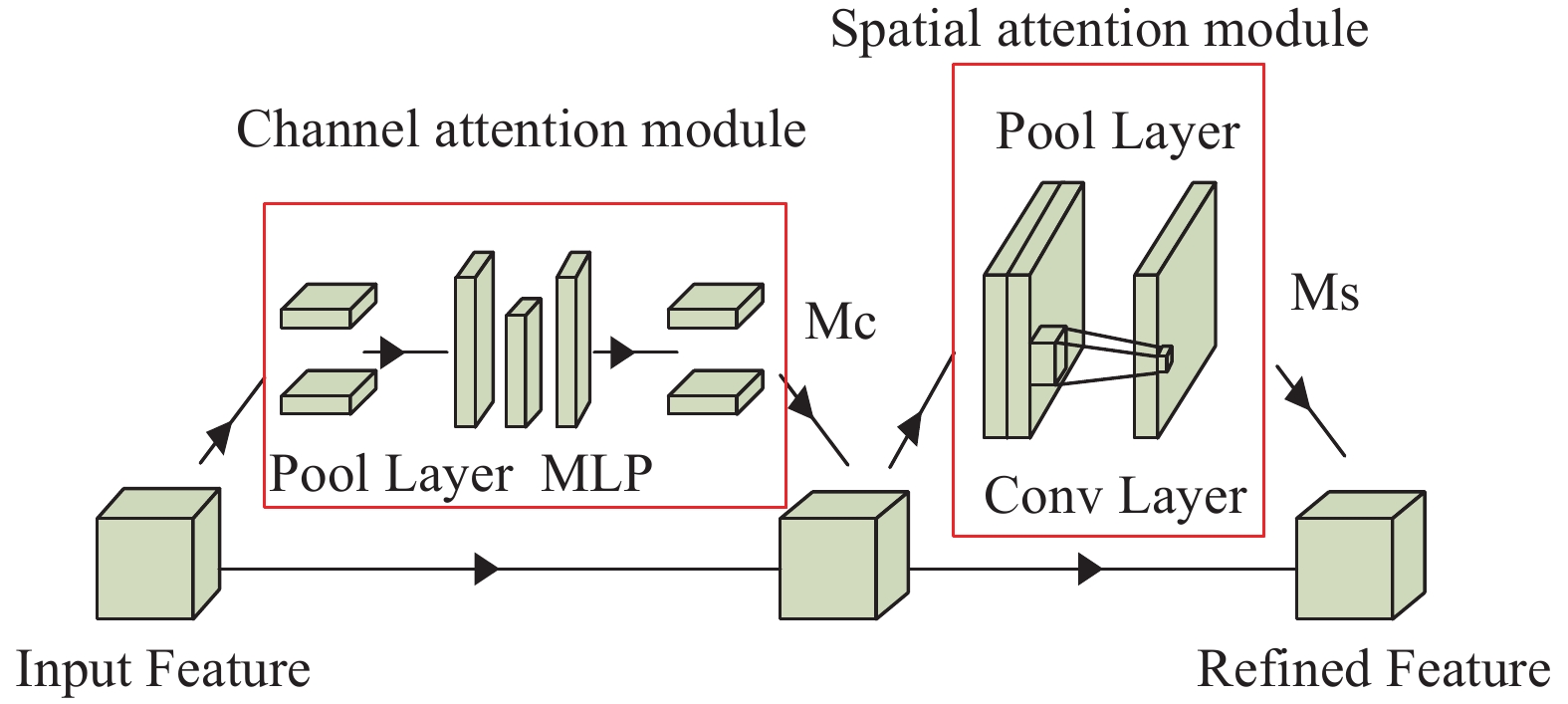

2 YOLOv5s算法改进 2.1 特征提取改进注意力机制类似人类的视觉感官,专注于感兴趣的事物,从繁多特征信息中提取对当前需求影响更大的信息,并为其分配权重,使模型学习更加高效。为了解决YOLOv5s对于特征信息无偏好问题,本文引入卷积注意力模块CBAM,以增强网络特征提取能力。

CBAM[19](convolutional block attention module)在神经网络中即插即用,可增强表征效果。其由专注于通道上类别信息的通道注意力模块CAM(channel attention module)[20]和专注于空间上位置信息的空间注意力模块SAM(spatial attention module)[21]构成,分别对通道和空间上特征信息进行加权操作,越是重要的特征给予的权重越高,获得更全面可靠的目标特征信息,强化计算资源对目标信息的分配,弱化无关信息的干扰,从而提高算法目标检测的性能,结构如图2所示。

|

| 图 2 CBAM注意力模块 |

由于CBAM即插即用的特性,添加在网络不同结构位置会产生不同的效果。本文首先将CBAM融入到C3_1模块中,添加在Resunit模块shortcut之前形成C3_1_C模块,如图3(a)所示。然后将C3_1_C模块添加在主干网络的两处位置,分别是替换主干网络里的所有C3_1模块,构成YOLOv5s_CBAM1模型,如图3(b)所示;添加在主干网络的最后一个C3_1层与SPPF层之间,构成YOLOv5s_CBAM2模型,如图3(c)所示。

|

| 图 3 添加CBAM的Backbone结构 |

2.2 特征融合改进

原网络的特征融合主要使用了FPN和PAN。通过图4可以看出,FPN实现自下而上的深层语义信息(有利于目标分类)传递给浅层位置信息(有利于目标定位),但理论上丢失了更多位置行信息。PANet结构是在FPN的基础上增加自上而下的浅层位置信息传递给深层语义信息,使预测特征图同时具备较高的语义信息和位置信息,从而增强检测性能。然而PANet没有将主干特征提取网络的原始特征信息直接融入到后续的特征中,导致主干部分原始特征的缺失,影响检测精度。

|

| 图 4 特征融合结构示意图 |

为了解决这个问题,在颈部层引入加权双向特征金字塔网络。BiFPN[22]在PANet的基础上进行改进,如图4(c)所示。绿色部分自下向上的通道,传递高层语义信息,增强目标分类能力;蓝色部分自上向下的通道,传递底层特征位置信息,增强目标定位能力;绿色部分通道连接同一层主干部分输入节点与输出节点,融合更多特征信息;P3层和P7层只有一条输入边的节点去除,简化了网络复杂度。为了使特征融合更加简单高效,引入权重参数,学习不同输入特征的重要性,对不同输入特征有区分的融合。即BiFPN实现了高效的双向跨层级且带权重特征图融合。

2.3 损失函数改进YOLOv5s使用CIoU Loss函数,其定义式为式(1),

| $ {L_{{\text{CIoU}}}} = 1 - {\text{IoU}} + \frac{{{\rho ^2}\left( {b,{b^{{\text{gt}}}}} \right)}}{{{c^{\text{2}}}}} + av $ | (1) |

| $ v = \frac{4}{{{{\text{π }}^2}}}{\left( {{\text{arctan}}\ \frac{{{w^{{\text{gt}}}}}}{{{h^{{\text{gt}}}}}} - {\text{arctan}}\ \frac{w}{h}} \right)^2} $ | (2) |

| $ \left\{ \begin{gathered} \frac{{{\partial {{v}}}}}{{{\partial{{w}}}}} = \frac{8}{{{\pi ^2}}}\left( {{\text{arctan}}\ \frac{{{w^{{\text{gt}}}}}}{{{h^{{\text{gt}}}}}} - {\text{arctan}}\ \frac{w}{h}} \right) \times \frac{h}{{{w^2} + {h^2}}} \\ \frac{{{\partial{{v}}}}}{{{\partial{{h}}}}} = - \frac{8}{{{\pi ^2}}}\left( {{\text{arctan}}\ \frac{{{w^{{\text{gt}}}}}}{{{h^{{\text{gt}}}}}} - {\text{arctan}}\ \frac{w}{h}} \right) \times \frac{w}{{{w^2} + {h^2}}} \\ \end{gathered} \right. $ | (3) |

式中:

虽然考虑了边界框回归的重叠面积、中心点距离、纵横比,但根据式(2),在预测框回归过程中,只要预测框和GT框的宽高纵横比呈线性比例,CIoU Loss中添加的相对比例的惩罚项便不再起作用。根据式(3),

EIoU Loss[23]函数对CIoU Loss函数做出改进,提出了直接对

| $ \begin{split} {L_{{\text{EIoU}}}} =& {L_{{\text{IoU}}}} + {L_{{\text{dis}}}} + {L_{{\text{asp}}}}= \\ & 1 - {\text{IoU}} + \frac{{{\rho ^2}\left( {b,{b^{{\text{gt}}}}} \right)}}{{{c^2}}} + \frac{{{\rho ^2}\left( {w,{w^{{\text{gt}}}}} \right)}}{{C_{\text{w}}^2}} + \frac{{{\rho ^2}\left( {h,{h^{{\text{gt}}}}} \right)}}{{C_{\text{h}}^2}} \end{split}$ | (4) |

其中

通过实验验证,在主干网络最后一个C3_1层与SPPF层之间添加CBAM模块得到C3_1_C模块后,提升的检测性能更佳,因此,本文以YOLOv5s为基础网络,综合以上方法改进得到YOLOv5s_CBE(CBAM+BiFPN+EIoU)算法,结构如图5所示。

|

| 图 5 改进后YOLOv5s_CBE结构图 |

3 实验分析 3.1 实验环境配置和训练参数选择

本文研究的应用环境如表1所示。模型训练的相关超参数:学习率过大会导致模型性能震荡,过小收敛速度慢,根据经验以及反复实验,学习率(lr0)设为0.01,学习动量(momentum)设为0.937;由于GPU等硬件配置性能的约束,训练进程数(workers)设为2,批次容量(batch_size)设为12;通过实验结果的mAP和best.pt权重文件在epoch为300左右表现较好,迭代次数(epochs)设为300。

| 配置名称 | 版本参数 |

| 操作系统 | Windows10 |

| GPU | NVIDIA GeForce RTX 2060 |

| CPU | Intel(R) Core(TM) i5-10400F CPU @ 2.90 GHz |

| 深度学习框架 | Python3.7、Pytorch1.8.0、Cuda10.2 |

3.2 数据采集

实验数据来源于包钢转炉炼钢现场使用的AMEPA公司的设备,架设在转炉下渣炉口前拍摄的下渣视频,筛选关键帧进行图像截取,选取其中的2000张构成数据集,按照7∶2∶1划分成训练集、测试集和验证集。结合专家经验,下渣状态分为5类(图6):挂渣卷渣出钢、炉口出渣、全渣出钢、正常出钢、混渣出钢。使用LabelImg标注软件对数据集进行标注,生成对应的.jpg文件和.txt文件。

|

| 图 6 下渣状态 |

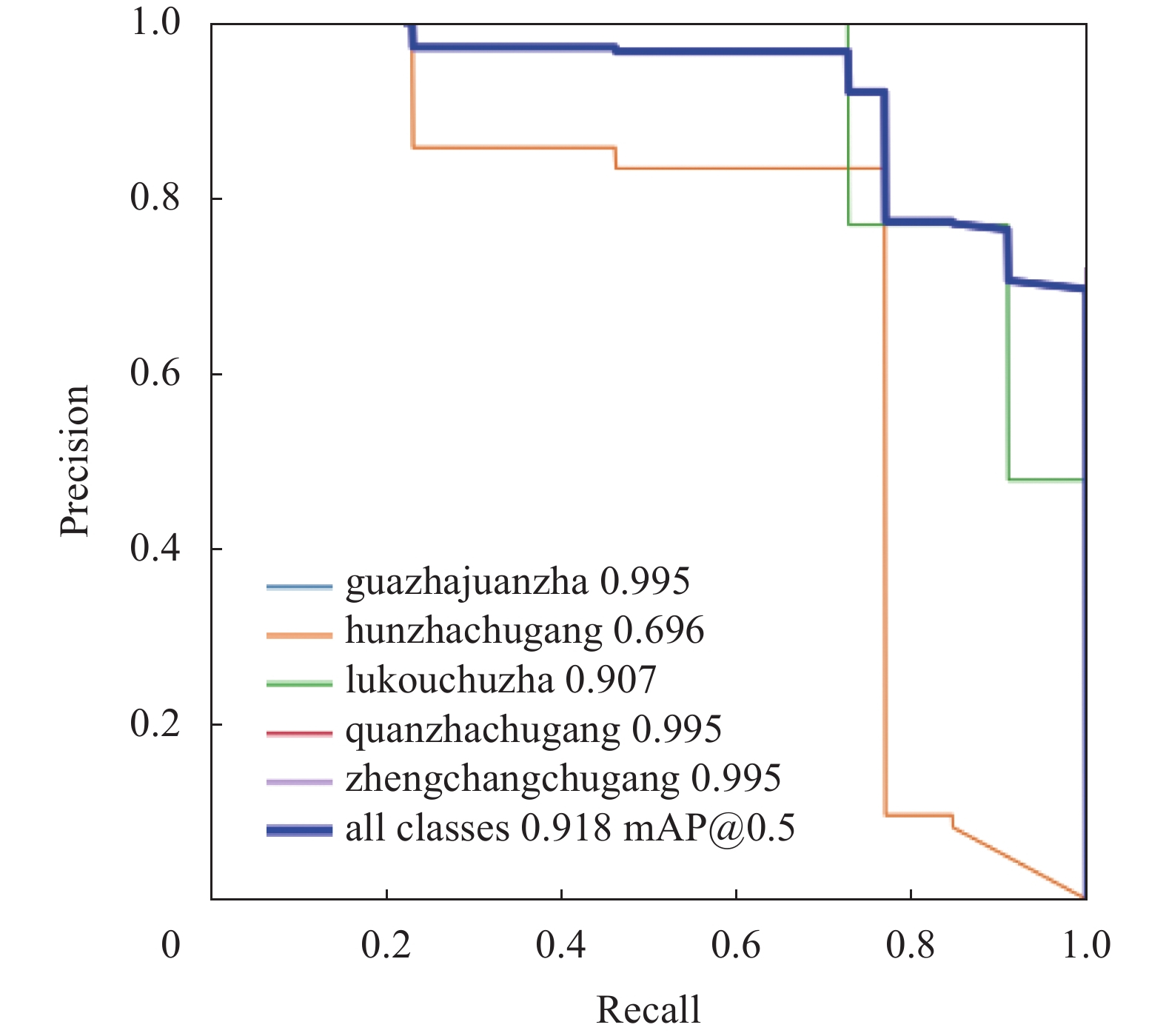

3.3 评价标准

模型性能的好坏,不仅要衡量检测出正确目标的数量,还应该评价模型是否能以较高的Precision检测出目标。因此本文以平均精度均值(mean average precision,mAP),每秒检测帧率(frame per second,FPS)作为评价模型检测性能的标准。mAP由精确度P(Precision)和召回率R(Recall)组成的P-R关系曲线图获得平均检测精度AP,再取所有类的平均值体现,如图7所示。

|

| 图 7 P-R曲线图 |

精确度定义式为(5),召回率定义式为(6),TP表示正确识别下渣状态的数量,FP表示错误识别下渣状态的数量,FN表示错误识别为非下渣状态的数量。

| $ P = \frac{{{\text{TP}}}}{{{\text{TP + FP}}}} $ | (5) |

| $ R = \frac{{{\text{TP}}}}{{{\text{TP + FN}}}} $ | (6) |

平均检测精度AP定义式为(7),即P-R曲线图围成的面积,mAP为对所有类别的AP取平均值,定义式为(8),ri表示按升序排列的Precison插值段第一个插值处对应的Recall值,Pinter表示ri对应的精确值,k表示类别数。

| $ {\text{AP}} = \mathop \sum \limits_{i = 1}^{n - 1} ({r_{i + 1}} - {r_i}){P_{{\text{inter}}}}\left( {{r_{i + 1}}} \right) $ | (7) |

| $ {\text{mAP}} = \frac{{ \displaystyle \sum \nolimits_{i = 1}^k {\text{A}}{{\text{P}}_i}}}{k} $ | (8) |

为了验证本文提出的基于YOLOv5s基础模型的改进效果,在保证数据集、训练的配置参数、平台框架相同的基础上,对测试集进行消融实验,结果如表2所示。

| 算法模型 | EIoU | CBAM | BiFPN | mAP@0.5/% | FPS/(f·s–1) |

| YOLOv5s | 87.2 | 78.7 | |||

| YOLOv5s_E | √ | 89.6 | 102.0 | ||

| YOLOv5s_C | √ | 90.0 | 75 | ||

| YOLOv5s_B | √ | 89.8 | 98.3 | ||

| YOLOv5s_CBE | √ | √ | √ | 91.8 | 87.7 |

“√”表示YOLOv5s中添加相应模块。由表2可知,添加相应模块后的检测精度和速度都得到不错的提升:YOLOv5s_E的FPS值提升显著;YOLOv5s_C 精度提升最高,速度有小幅降低;YOLOv5s_B速度、精度均得到一定程度提升。而最终改进算法YOLOv5s_CBE 的mAP@0.5达到了所有模型最高的91.8%,相比基础模型提升了4.6%,FPS是87.7 f/s,相对于单独添加模块的检测速度有所下降,但比基础模型提升了11.4%。上述结果表明,添加CBAM加强了模型的特征提取能力,但增加了模型复杂度,精度得到提升,速度降低;而EIoU优化了模型的收敛速度,使检测速度得到改善,同时通过BiFPN多尺度融合机制,进一步提升模型检测性能。说明本文改进算法保持实时检测的同时,能够提高检测精度。图8为改进前后检测效果对比图。可以看到,改进后模型有效地减少了漏检、误检。

|

| 图 8 改进前后结果对比 |

3.5 对比试验

为进一步体现本文算法的检测效果,将本文的改进算法与YOLOv5s、SSD[24]、YOLOv3等算法在转炉下渣图像数据集上进行对比验证,结果见表3。

| 模型算法 | mAP@0.5/% | 权重大小/MB | FPS/(f·s–1) |

| YOLOv3 | 69.0 | 235 | 42 |

| SSD | 83.8 | 92.6 | 68 |

| YOLOv5s | 87.2 | 13.7 | 78.7 |

| YOLOv5s_CBE | 91.8 | 15.7 | 87.7 |

由表可知,改进后的YOLOv5s_CBE算法无论是检测精度,还是检测速度,都明显优于其他算法。相比于YOLOv3模型mAP提高了22.8%,权重大小只有YOLOv3的6.7%,FPS提升了108.8%;相比于SSD模型,mAP值提高了8%,权重大小减小了83%,FPS提升了28.9%;相比于权重大小接近的YOLOv5s,mAP提高了4.6%,FPS提升了11.4%。综合来看,本文提出的算法在维持了原模型轻量化的同时,在检测精度和速度上也都优于其他算法,体现了本文算法可以很好地应用于转炉下渣状态检测。

4 结束语本文基于包钢现场基础自动化条件具备的蕴含丰富生产信息的闲置彩色下渣图像数据集,在YOLOv5s基础上引入注意力机制、双向加权特征金字塔结构、EIoU损失函数,显著地提升了算法的检测精度和速度,得到改进算法YOLOv5s_CBE,实现了对不同下渣状态精准快速地识别与目标定位,有效地避免了误检、漏检。通过实验对比,本文算法相比于YOLOv5s以及其他主流算法,mAP和FPS均得到不同程度提高,可为后续及时挡渣操作提供指导,为实现钢水无渣化打下基础,且自身的轻量化特性为部署到移动端提供了支持,可实现多方位实时检测。

| [1] |

相伟. 转炉炼钢和电炉炼钢的优缺点比较[J].

冶金与材料, 2022, 42(2): 45-46.

|

| [2] |

饶磊. 转炉钢渣成分、结构及性能间内在规律及其应用研究[D]. 北京: 北京科技大学, 2020.

RAO L. Study on the internal laws of composition,structure and properties of converter steel slag and its application [D]. Beijing: University of Science and Technology Beijing, 2020.

|

| [3] |

陈灵光, 杨晓江, 李培玉, 等. 一种改进的转炉出钢下渣检测方法及其应用[J].

钢铁研究学报, 2012, 24(11): 56-62.

YANG L G, YANG X J, LI P Y, et al. An improved converter tapping slag detection method and its application[J].

Journal of Iron and Steel Research, 2012, 24(11): 56-62.

|

| [4] |

JULIUS E, THEISSEN W. Function and application of an electromagnetic slag detection system[J].

World Steel Metalwork. Export Man., 1987, 8: 51-54.

|

| [5] |

张子淼, 刘斌, 赵盼, 等. 基于红外测温原理的转炉下渣检测系统[J].

红外与激光工程, 2014, 43(2): 469-473.

ZHANG Z M, LIU B, ZHAO P, et al. Slag detection system based on infrared temperature measurement[J].

Infrared and Laser Engineering, 2014, 43(2): 469-473.

DOI:10.3969/j.issn.1007-2276.2014.02.024 |

| [6] |

李爱莲, 刘浩楠, 郭志斌, 等. 改进ResNet101网络下渣出钢状态识别研究[J].

中国测试, 2020, 46(11): 116-119+125.

LI A L, LIU H N, GUO Z B, et al. Study on the status identification of slag steel under improved ResNet101 network[J].

China Measurement & Test, 2020, 46(11): 116-119+125.

DOI:10.11857/j.issn.1674-5124.2020030022 |

| [7] |

张幸光. 基于二次阈值分割的红外下渣检测系统研究[D]. 南京: 南京理工大学, 2016.

|

| [8] |

何伟. 转炉出钢下渣检测方法与挡渣设备的研究[D]. 哈尔滨: 哈尔滨工业大学, 2017.

HE W. A study on detection m ethod of ladle slag and slag equipment[D].Harbin: Harbin Institute of Technology, 2017.

|

| [9] |

谢秋菊, 吴梦茹, 包军, 等. 融合注意力机制的个体猪脸识别[J].

农业工程学报, 2022, 38(7): 180-188.

XIE Q J, WU M R, BAO J, et al. Individual pig face recognition combined with attention mechanism[J].

Transactions of the Chinese Society of Agricultural Engineering, 2022, 38(7): 180-188.

DOI:10.11975/j.issn.1002-6819.2022.07.020 |

| [10] |

陈欣佳, 刘艳霞, 洪晓斌, 等. 基于SSD-CF的无人艇目标检测跟踪方法[J].

中国测试, 2019, 45(2): 145-150.

CHEN X J, LIU Y X, HONG X B, et al. Unmanned boat target detection and tracking method based on SSD-CF[J].

China Measurement & Test, 2019, 45(2): 145-150.

|

| [11] |

彭伟康, 陈爱军, 吴东明, 等. 基于改进Faster R-CNN的水准泡缺陷检测方法[J].

中国测试, 2021, 47(7): 6-12.

PENG W K, CHEN A J, WU D M, et al. Defect detection method of level bubble based on improved Faster R-CNN[J].

China Measurement & Test, 2021, 47(7): 6-12.

|

| [12] |

范玉莹, 何赟泽, 孙高森, 等. 无人机图像风力发电机轮毂中心检测与跟踪[J].

中国测试, 2022, 48(7): 90-96.

FAN Y Y, HE Y Z, SUN G S, et al. Wind turbine hub center detection and tracking based on UAV images[J].

China Measurement & Test, 2022, 48(7): 90-96.

|

| [13] |

REDMON J, DIVVALA S, GIRSHICK R, et al. You only look once: Unified, real-time object detection[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016.

|

| [14] |

REDMON J, FARHADI A. YOLO9000: better, faster, stronger[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017.

|

| [15] |

REDMON J, FARHADI A. Yolov3: An incremental improvement[EB/OL]. (2018-04-08)[2022-08-01]. https://arxiv.org/pdf/1804.02767.pdf.

|

| [16] |

BOCHKOVSKIY A, WANG C Y, LIAO H Y M. Yolov4: Optimal speed and accuracy of object detection[EB/OL]. (2020-04-23)[2022-08-01]. https://arxiv.org/abs/2004.10934v1.

|

| [17] |

LIN T Y, DOLLÁR P, GIRSHICK R, et al. Feature pyramid networks for object detection[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017.

|

| [18] |

LIU S, QI L, QIN H, et al. Path aggregation network for instance segmentation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern recognition, 2018.

|

| [19] |

WOO S, PARK J, LEE J Y, et al. Cbam: Convolutional block attention module[C]//Proceedings of the European Conference on Computer Vision (ECCV), 2018.

|

| [20] |

ZHOU B, KHOSLA A, LAPEDRIZA A, et al. Learning deep features for discriminative localization[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016.

|

| [21] |

ZHU X, CHENG D, ZHANG Z, et al. An empirical study of spatial attention mechanisms in deep networks[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision, 2019.

|

| [22] |

TAN M, PANG R, LE Q V. Efficientdet: Scalable and efficient object detection[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2020.

|

| [23] |

ZHANG Y F, REN W, ZHANG Z, et al. Focal and efficient IOU loss for accurate bounding box regression[J]. arXiv preprint arXiv: 2101.08158, 2021.

|

| [24] |

LIU W, ANGUELOV D, ERHAN D, et al. Ssd: Single shot multibox detector[C]//European Conference on Computer Vision, 2016.

|

2024, Vol. 50

2024, Vol. 50

,

,