文章信息

- 朱菊香, 谷卫, 罗丹悦, 潘斐, 张赵良

- ZHU Juxiang, GU Wei, LUO Danyue, PAN Fei, ZHANG Zhaoliang

- 基于注意力机制的CNN-ILSTM地铁站PM2.5 预测建模

- Prediction modeling of PM2.5 in subway station based on attention mechanism and CNN-ILSTM

- 中国测试, 2024, 50(7): 53-62

- CHINA MEASUREMENT & TEST, 2024, 50(7): 53-62

- http://dx.doi.org/10.11857/j.issn.1674-5124.2022070028

-

文章历史

- 收稿日期: 2022-07-05

- 收到修改稿日期: 2022-09-11

2. 南京信息工程大学自动化学院,江苏 南京 210000

2. School of Automation, Nanjing University of Information Technology, Nanjing 210000, China

近年来,随着我国城市轨道交通的快速发展,地铁因其方便、高效、安全等特点,已成为日运载量最大的城轨交通工具[1]。尽管地铁系统为人们的出行提供了方便,但是其室内存在空气污染的问题,尤其是可吸入颗粒物(PM2.5 )严重影响通勤者和地铁工作人员的身体健康[2]。因此,精准预测PM2.5 浓度对于开发预警系统和调节通风系统以确保通勤者和地铁工作人员的健康具有重要的指导意义[3]。

目前,虽然地铁环境监控系统能够监测PM2.5 浓度的变化,但依然存在监控系统高成本、高功耗和低效率的问题[4]。为了提高地铁站PM2.5 监测的有效性和准确性,降低监测成本,有必要建立更合理的预测模型。目前用于时间预测的模型有人工神经网络(ANN)、支持向量回归(SVR)、自回归综合移动平均(ARIMA)和随机森林回归(RFR)等。Nouri等[5]利用人工神经网络和主成分分析法来预测PM2.5 的浓度,虽然利用了PM2.5 的空间特征,但并未考虑PM2.5 在时间和空间上依赖性,导致预测精度较低;Li等[6]使用支持向量机回归(SVR)预测PM2.5 。然而,由于PM2.5 数据的不稳定特性,SVR很难达到高拟合度。刘拥民等[7]使用XGBoost-ARIMA混合模型对城市中PM2.5 浓度进行预测,但无法处理环境数据中随机不确定性,因此预测精度较低。Feng等[8]结合随机森林回归(RFR)和RNN来分析和预测未来24 h的PM2.5 ,但对于非线性PM2.5 的预测,RFR存在过拟合的风险。由于地铁站室内空气环境的动态性质,递归神经网络(RNN)合适模拟PM2.5 的时间演变,因为RNN可以处理任意输入序列,从而保证学习时间序列的能力[9-10]。然而,当传统RNN存在长时间滞后时,它可能会遇到“梯度消失”和“梯度爆炸”等问题,这些基于RNN的方法也没有充分利用空间特征[11-12]。此外,不同时间特征形成的状态也会对未来的PM2.5 浓度产生不同的影响[13]。LSTM的出现可以缓解RNN训练过程中的“梯度消失”和“梯度爆炸”问题。白盛楠 等[14]使用LSTM预测空气污染物的变化,由于预测模型单一,对特征值的提取不够充分,难以实现高精度预测。赵彦明等[15]提出基于时空相关性LSTM的PM2.5 预测,但LSTM无法提取环境数据不同时间状态下的特征值,预测精度较低。现有的研究没有考虑过去不同时间的特征状态对地铁站内污染物的影响,而只提取了历史数据的时间相关特征,导致预测精度较低。

为了解决上述问题,本文提出了一种基于注意力机制(attention)的卷积神经网络(CNN)和改进长短期记忆(ILSTM)模型组合的CNN-ILSTM-attention混合神经网络模型,用于预测地铁站室内PM2.5 的浓度。所提出的CNN-ILSTM-attention模型包括一维卷积神经网络(CNN)、改进长短期记忆(ILSTM)网络和注意力机制网络。为了克服传统RNN的“梯度消失”和“梯度爆炸”以及LSTM捕捉污染物相关时间序列数据的时空相关性和相互依赖性不充分的问题,对LSTM网络进行改进,删除了LSTM中的输出门,改进了LSTM中输入门和遗忘门,并引入CIM来防止学习过程中的过饱和现象。同时,结合一维CNN的目的是从地铁站室内空气中提取时空特征及局部空间相关性特征。注意力机制在预测模型中对过去的特征状态进行加权,以提高预测精度。因此,注意力机制应用于CNN-ILSTM模型,用于捕捉不同时间PM2.5 浓度的过去特征状态。通过无锡某地铁站采集的环境数据进行验证,实验表明,所建立的PM2.5 预测模型可以有效地提高预测精度和泛化能力。

1 基于注意力机制的CNN-ILSTM的PM2.5 浓度预测 1.1 卷积神经网络(CNN)CNN是一种多层神经网络结构,具有强大的网格数据处理能力和深度监督学习结构,能够处理时间序列数据和图像数据。典型的CNN结构主要包括输入层、卷积层、池化层、全连接层和输出层。输入层中的信息通过卷积层和池化层中的特征变换和提取进行处理,卷积层和池化层的本地信息由全连接层进一步集成,并通过输出层映射输出信号。图1为一维CNN的网络结构。卷积层是CNN中最重要、最独特的一层,因为它可以通过卷积核提取输入变量的特征,与全连接层的神经网络不同,CNN的卷积层只连接前一层的部分神经元,卷积核的规模小于输入矩阵的规模。卷积层使用卷积核运算而不是一般的矩阵运算来输出特征映射。变量特征中每个元素的计算公式如下式所示:

|

| 图 1 CNN网络结构 |

| $ {y}_{i,j}^{{\rm out}}={f}_{{\rm cov}}\left(\sum _{m=0}^{k}\sum _{n=0}^{k}{w}_{m,n}{x}_{i+m,j+n}^{{\rm in}}+b\right) $ | (1) |

式中:

输入矩阵通常使用多个核进行卷积运算。每个卷积核从输入矩阵中提取一个特征,并生成一个特征映射。之后,池化层减少了前一个特征映射的长度和宽度,并通过采样提高计算效率。

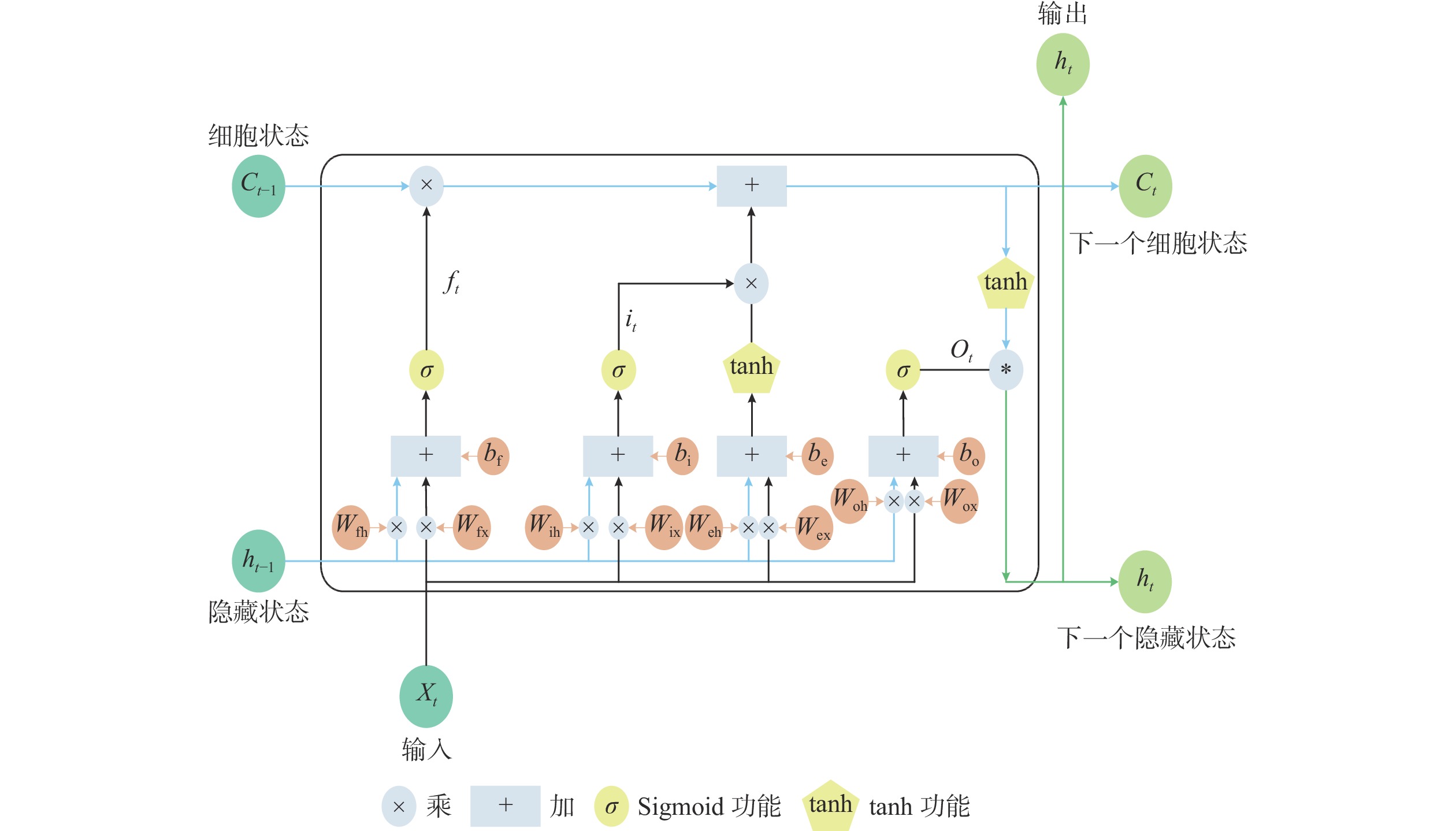

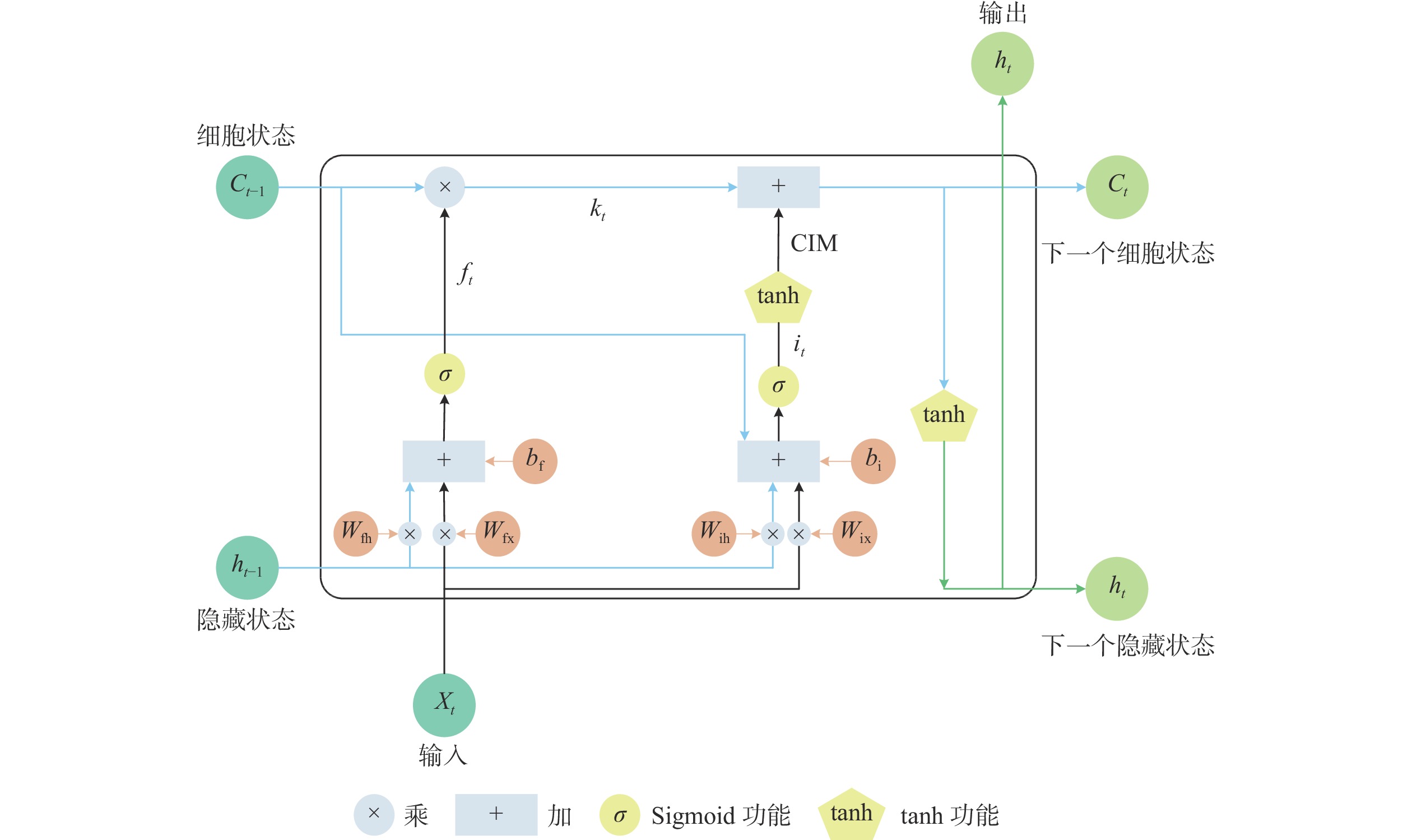

1.2 改进长短期记忆网络(ILSTM)长短期记忆神经网络(LSTM)是一种特殊的RNN,LSTM模型具备了传统RNN的重复模块链式结构,区别于传统RNN的单一网络层,LSTM单元内部具有4个网络层。LSTM在挖掘序列数据的长期依赖关系方面具有很好的优势,将LSTM细胞加入神经元内部,即细胞中增加了门控结构,从而更新“细胞状态”。门控结构的作用是对流入的信息进行判断和甄别,来决定阻止或者允许信息的流入,从而选择性输入和丢弃信息,还能增加记忆单元,保存历史信息、神经元的长期状态。LSTM模型的内部结构如图2所示。门控递归单元(GRU)只有两个门。GRU将LSTM的输入门和遗忘门合二为一,称为更新门。基于门控技术,本文提出的ILSTM模型由输入门和遗忘门组成,如图3所示。与LSTM相比,ILSTM删除了输出门。与GRU相比,ILSTM结构更简单。LSTM、GRU和ILSTM的参数如表1所示。与LSTM相比,ILSTM将权重参数从8减少到4,将偏差参数从4减少到2。与GRU相比,ILSTM将权重参数从6减少到4,将偏差参数从3减少到2。

|

| 图 2 LSTM神经元结构 |

|

| 图 3 改进的LSTM神经元结构图 |

在算法方面,ILSTM将前一时刻的单元状态

| $ \sigma \left(x\right)=\frac{1}{1+{\mathrm{e}}^{-x}} $ | (2) |

| $ {f}_{t}=\sigma \left({W}_{{\rm fh}}\cdot {h}_{t-1}+{W}_{{\rm fx}}\cdot {x}_{t}+{b}_{{\rm f}}\right) $ | (3) |

主线遗忘

| $ {k}_{t}={f}_{t}\times {C}_{t-1} $ | (4) |

输入门

| $ i_t=\sigma\left(W\mathrm{_{ih}}\cdot h_{t-1}+W_{\mathrm{ix}}\cdot x_t+C_{t-1}+b\mathrm{_i}\right) $ | (5) |

其中

由于Sigmoid激活函数的特性,当x的值在[–3,3]时,Sigmoid激活函数的值将进入过饱和区间。因此,在式(5)中,当输入数据进入输入门的过饱和区间时,其值不会发生明显变化,从而降低了学习的灵敏度。为了防止这种现象,在ILSTM模型中加入转换信息模块(CIM),如下式所示:

| $ {\mathrm{CIM}}={\mathrm{tanh}}\left({i}_{t}\right) $ | (6) |

CIM输出的值将大大降低过饱和度,显著差异使模型计算更容易识别,从而使模型学习更灵敏。

式(7)表明,

| $ {C}_{t}={k}_{t}+{\mathrm{CIM}} $ | (7) |

| $ {h}_{t}={\mathrm{tanh}}\left({C}_{t}\right) $ | (8) |

ILSTM推导公式如下:ILSTM的提出是为了解决传统RNN的“梯度消失”和“梯度爆炸”以及LSTM捕捉污染物相关时间序列数据的时空相关性和相互依赖性不充分的问题,以提高模型的预测精度。输入门和遗忘门使用两个参数矩阵

| $ \frac{\partial {L}}{\partial \boldsymbol{W}}={\sum} _{{t}=1}^{{T}} \frac{\partial {{L}}_{{t}}}{\partial \boldsymbol{W}} $ | (9) |

RNN通过下式更新

| $ {\boldsymbol{W}}={\boldsymbol{W}}-\frac{\partial {L}_{t}}{\partial {\boldsymbol{W}}} $ | (10) |

其中

| $ \frac{\partial {{L}}_{{k}}}{\partial \boldsymbol{W}}=\frac{\partial {{L}}_{{k}}}{\partial {{h}}_{{k}}}\frac{\partial {{h}}_{{k}}}{\partial {C}_{{k}}}\frac{\partial {C}_{{k}}}{\partial {C}_{{k}-1}}\cdots \frac{\partial {C}_{2}}{\partial {C}_{1}}\frac{\partial {C}_{1}}{\partial \boldsymbol{W}} $ | (11) |

式(11)可以简化为:

| $ \frac{\partial {L}_{k}}{\partial {\boldsymbol{W}}}=\frac{\partial {L}_{k}}{\partial {h}_{k}}\frac{\partial {h}_{k}}{\partial {C}_{k}}\cdots \frac{\partial {C}_{2}}{\partial {C}_{1}}\frac{\partial {C}_{1}}{\partial {\boldsymbol{W}}}=\frac{\partial {L}_{k}}{\partial {h}_{k}}\frac{\partial {h}_{k}}{\partial {C}_{k}}\left(\prod _{t=2}^{k} \frac{\partial {C}_{t}}{\partial {C}_{t-1}}\right)\frac{\partial {C}_{1}}{\partial {\boldsymbol{W}}} $ | (12) |

其中,

| $ {C}_{t}={f}_{t}\times {C}_{t-1}+{\rm CIM} $ | (13) |

而

| $ {C}_{t}={f}_{t}\times {C}_{t-1}+{\rm tanh}\left({i}_{t}\right) $ | (14) |

而

| $ \frac{\partial {C}_{t}}{\partial {C}_{t-1}}={f}_{t}+\left(1-{\mathrm{tanh}}{\left({i}_{t}\right)}^{2}\right){\left({i}_{t}\right)}^{{'}} $ | (15) |

总损失可以写成:

| $ \frac{\partial {L}_{k}}{\partial {\boldsymbol{W}}}=\frac{\partial {L}_{k}}{\partial {h}_{k}}\frac{\partial {h}_{k}}{\partial {C}_{k}}\left(\prod _{t=2}^{k} \left({f}_{t}+\left(1-{\mathrm{tanh}}{\left({i}_{t}\right)}^{2}\right){\left({i}_{t}\right)}'\right)\right)\frac{\partial {C}_{l}}{\partial {\boldsymbol{W}}} $ | (16) |

此时记

| $ x={W}_{{\rm fh}}\cdot {h}_{t-1}+{W}_{{\rm fx}}\cdot {x}_{t}+{b}_{{\rm f}} $ | (17) |

那么

| $ {f}_{t}=\sigma \left({W}_{{\rm fh}}\cdot {h}_{t-1}+{W}_{{\rm fx}}\cdot {x}_{t}+{b}_{{\rm f}}\right)=\sigma \left(x\right) $ | (18) |

记

| $ y={W}_{{\rm ih}}\cdot {h}_{t-1}+{W}_{{\rm ix}}\cdot {x}_{t}+{c}_{t-1}+{b}_{{\rm i}} $ | (19) |

那么

| $ {i}_{t}=\sigma \left({W}_{{\rm ih}}\cdot {h}_{t-1}+{W}_{{\rm ix}}\cdot {x}_{t}+{c}_{t-1}+{b}_{{\rm i}}\right)=\sigma \left(y\right) $ | (20) |

那么式(16)可以写成:

| $ \begin{split} \frac{\partial {L}_{k}}{\partial {\boldsymbol{W}}}=&\frac{\partial {L}_{k}}{\partial {h}_{k}}\frac{\partial {h}_{k}}{\partial {C}_{k}}\\ &\left(\prod _{t=2}^{k} \left(\sigma \left(x\right)+\left(1-{\mathrm{tanh}}{\left(\sigma \left(y\right)\right)}^{2}\right){\left(\sigma \left(y\right)\right)}'\right)\right)\frac{\partial {C}_{l}}{\partial {\boldsymbol{W}}} \end{split} $ | (21) |

此时记

| $ {\textit{z}}\left(x,y\right)=\sigma \left(x\right)+\left(1-{\mathrm{tanh}}{\left(\sigma \left(y\right)\right)}^{2}\right){\left(\sigma \left(y\right)\right)}' $ | (22) |

那么公式(21)可以写成:

| $ \frac{\partial {{L}}_{{k}}}{\partial \boldsymbol{W}}=\frac{\partial {{L}}_{{k}}}{\partial {{h}}_{{k}}}\frac{\partial {{h}}_{{k}}}{\partial {{C}}_{{k}}}\left(\prod _{{t}=2}^{{k}} \left({\textit{z}}\left(x,y\right)\right)\right)\frac{\partial {{C}}_{{l}}}{\partial \boldsymbol{W}} $ | (23) |

此时函数的梯度如公式(23)所示。函数的梯度为

在堆叠的ILSTM层特征中提取长期依赖关系后,其输出将被用作注意层的输入。每个隐藏状态的重要性由添加的注意层自动学习。注意机制可以简单地解释为加权总和。它首先计算输入特征的重要性;然后,应用softmax函数以确保所有权重之和为1。权重和输入特征会相应地相乘,最终将它们相加得到输出。

注意机制可以自动为不同时间阶段的不同特征分配不同权重,以区分它们的重要性,并且可以实现精确的时空可解释性。考虑过去状态不同特征时的PM2.5 ,注意力机制允许模型捕捉PM2.5 浓度最重要的部分。在提出的CNN-ILSTM-attention混合模型中,为了充分利用过去状态的信息,在ILSTM层中增加了一个注意层,它将过去不同特征状态的重要程度排序如下,其中

| $ {{\boldsymbol{u}}}_{t}= {\rm tanh}\left({W}_{h}+{b}_{t}\right) $ | (24) |

| $ {\alpha }_{t}=\frac{{\rm exp}\left({{\boldsymbol{u}}}_{t}^{{\rm T}}{\boldsymbol{v}}\right)}{{\displaystyle \sum} _{t}{\rm exp}\left({{\boldsymbol{u}}}_{t}^{{\rm T}}{\boldsymbol{v}}\right)} $ | (25) |

| $ {\boldsymbol{s}}={\sum} _{t}{\alpha }_{t}{{\boldsymbol{h}}}_{{\boldsymbol{t}}} $ | (26) |

式中:

根据特征状态矩阵

CNN-ILSTM结合了CNN和ILSTM的优点,并在此基础上加入注意力机制,提出CNN-ILSTM-attention混合神经网络模型。该模型包括一个输入层、一个卷积层、两个ILSTM层、一个注意层和一个全连接层。设置一维CNN层卷积核为64,内核大小为32,并在一维CNN中添加最大池化层,激活函数为ReLU。卷积层和池化层中的stride=1。设置双层ILSTM网络,每层的隐藏单元个数为60,并在ILSTM网络中加入Dropout,设置其值为0.4,应用Dropout层可以防止模型过拟合。梯度下降的方式采用Adam训练算法,它能自动更新ILSTM网络的权重和偏置。本文提出的基于注意力机制的CNN-ILSTM模型具体实施步骤如下:首先,将数据输入模型,通过CNN的输入层、卷积层和池化层提取输入数据的特征,将得到的特征展平成一维阵列,作为时间序列输入ILSTM层。其次,CNN层的输出被送入第一个ILSTM层,该层捕获变量之间的长期依赖关系,并将每个ILSTM层的所有隐藏状态作为注意层的输入,注意层能够学习这些隐藏层状态的重要性。最后,通过全连接层得到PM2.5 预测结果。图4为CNN-ILSTM-attention神经网络结构图。

|

| 图 4 CNN-ILSTM-attention神经网络结构图 |

2 基于注意力机制的CNN-ILSTM的PM2.5 预测建模 2.1 数据来源和处理

本文采用的数据是无锡某地铁站内的环境传感器采集的空气质量数据,包括PM2.5 、PM10、一氧化碳、二氧化硫、温度和湿度。环境传感器以1 min为采集间隔,由传感器自动采集,共采集1440组数据。其中1120组数据作为训练样本,剩下320组数据作为测试样本检验CNN-ILSTM-attention模型对于PM2.5 浓度预测的准确性。

一旦将未经处理的原始数据输入模型,训练速度就会减慢,预测结果也会受到影响,因此为了进一步提高模型的预测精度和模型的收敛速度,需要将输入量进行归一化处理。预测模型采用最大最小值标准化(min-max normalization),将数据归一化到[0,1]之间,其转换如下式所示:

| $ Y\left(x\right)=\frac{x-{\rm min}\left(x\right)}{{\rm max}\left(x\right)-{\rm min}\left(x\right)} $ | (27) |

式中:

为了评估CNN-ILSTM-attention模型的预测精度,选用均方根误差(RMSE)、平均绝对误差(MAE)和拟合度(r2)对算法模型进行评价。其计算公式如下式所示:

| $ \mathrm{R}\mathrm{M}\mathrm{S}\mathrm{E}=\sqrt{\frac{\displaystyle \sum _{t=1}^{m}{\left({{\textit{z}}}_{t}-{x}_{t}\right)}^{2}}{m}} $ | (28) |

| $ \mathrm{M}\mathrm{A}\mathrm{E}=\frac{\displaystyle \sum _{i=1}^{m}\left|{{\textit{z}}}_{t}-{x}_{t}\right|}{m} $ | (29) |

| $ {r}^{2}=1-\frac{\displaystyle \sum _{t=1}^{m}{\left({{\textit{z}}}_{t}-{x}_{t}\right)}^{2}}{\displaystyle \sum _{t=1}^{m}{\left({{\textit{z}}}_{t}-{\bar {x}_{t}}\right)}^{2}} $ | (30) |

式中:

一般的时间预测问题中,当面临长序列问题时,就会陷入瓶颈。一种解决方法就是引入注意力机制。注意力机制可以允许模型聚焦关注输入序列中所需要的部分。引入了注意力机制后的模型,它可以将输入序列中相关部分的作用进行放大,以实现比没有注意力的模型更好的效果。通常,注意力机制的表现形式可以看作是一种加权求和。在本文中,为了提高集成神经网络模型的可扩展性和准确性,将注意力机制引入CNN-ILSTM网络模型中。

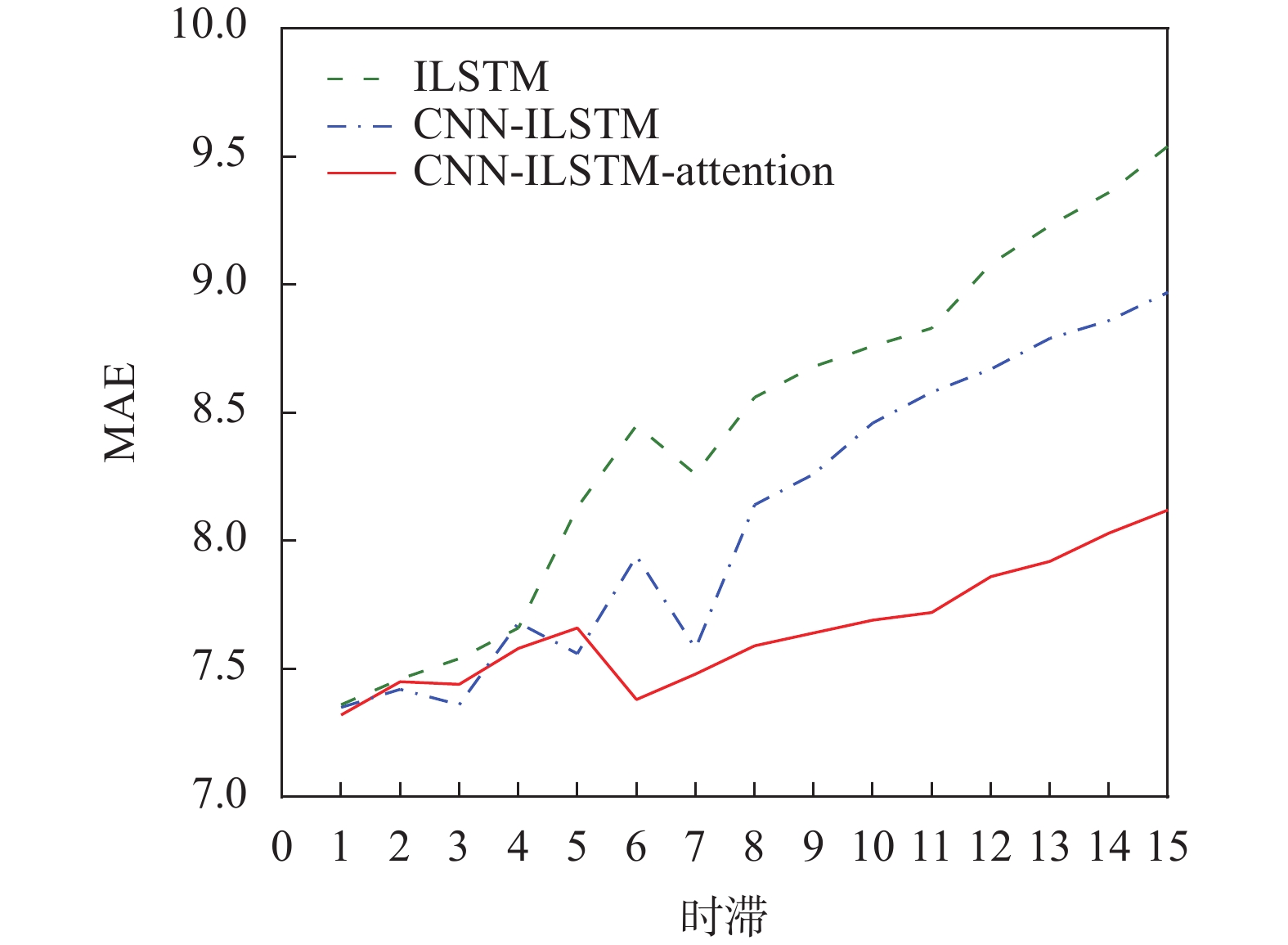

本文将CNN-ILSTM-attention模型、CNN-ILSTM模型和ILSTM模型在1~15之间的时滞进行对比,以研究注意机制的有效性。时滞越大,提取有用特征的难度就越大。从图5可以看出,随着时滞的增加,MAE变得越来越大。当时滞变大时,ILSTM模型和CNN-ILSTM模型都迅速退化,而CNN-ILSTM-attention模型性能保持稳定。结果表明,CNN-ILSTM-attention模型具有较强的稳定性和鲁棒性,这是因为注意机制考虑了不同隐藏状态的重要性,并将更多注意力集中在更重要的状态上。

|

| 图 5 不同时滞下3种模型的MAE的比较 |

3.2 预测模型收敛性比较

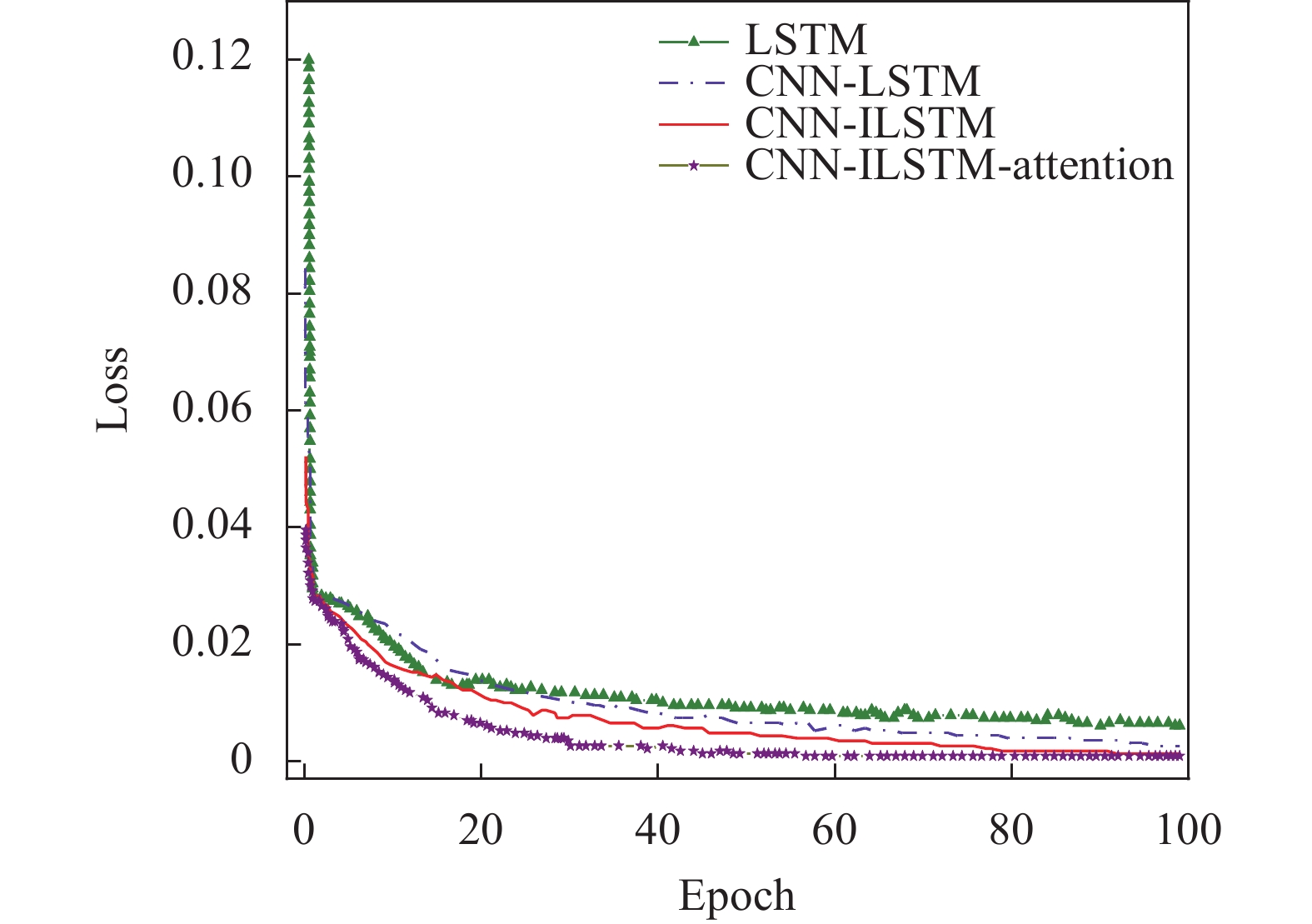

设置合适的模型参数后,需要验证CNN-ILSTM-attention在训练过程中是否收敛。因此,计算了CNN-ILSTM-attention模型在PM2.5 浓度预测任务中的训练损失,并将结果与另外3种深度学习模型(LSTM、CNN-LSTM和CNN-ILSTM)进行了比较。所有预测模型的参数相同,使用数据归一化后的均方误差(MSE)作为损失函数进行训练。图6为4种模型训练损失函数。从图中可以看出,所有模型在Epoch=40处收敛。在预测过程中Epoch=40后,4个模型的MSE损失接近,但CNN-ILSTM-attention模型的MSE损失略小于LSTM、CNN-LSTM和CNN-ILSTM 3个模型,且拥有更快的收敛速度。因此,CNN-ILSTM-attention模型比ILSTM模型、CNN-LSTM和CNN-ILSTM模型具有更好的收敛结果。

|

| 图 6 4种模型训练损失函数 |

3.3 预测模型性能比较

为了验证所提出的CNN-ILSTM-attention模型的有效性,本文从两个方面进行对比。

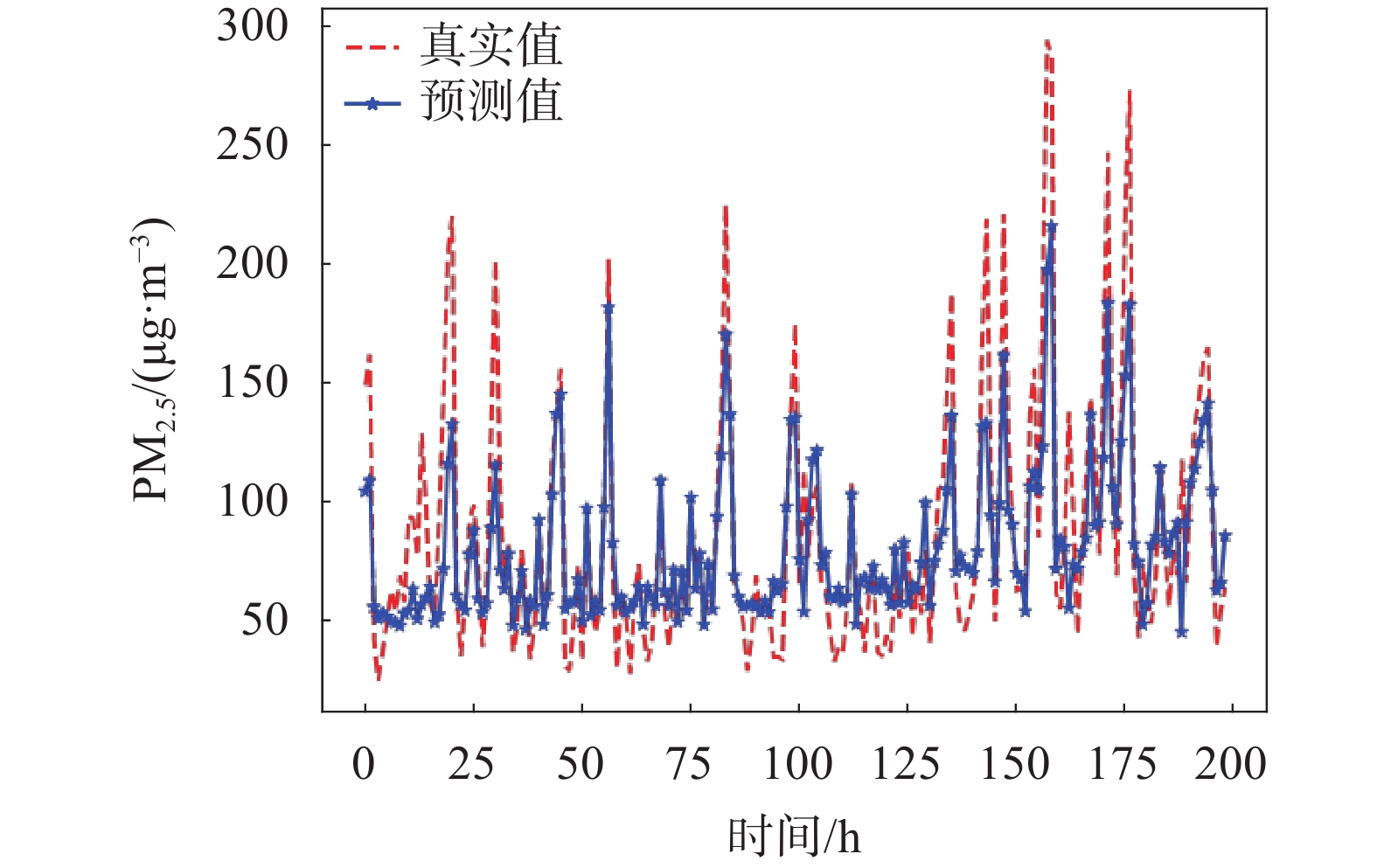

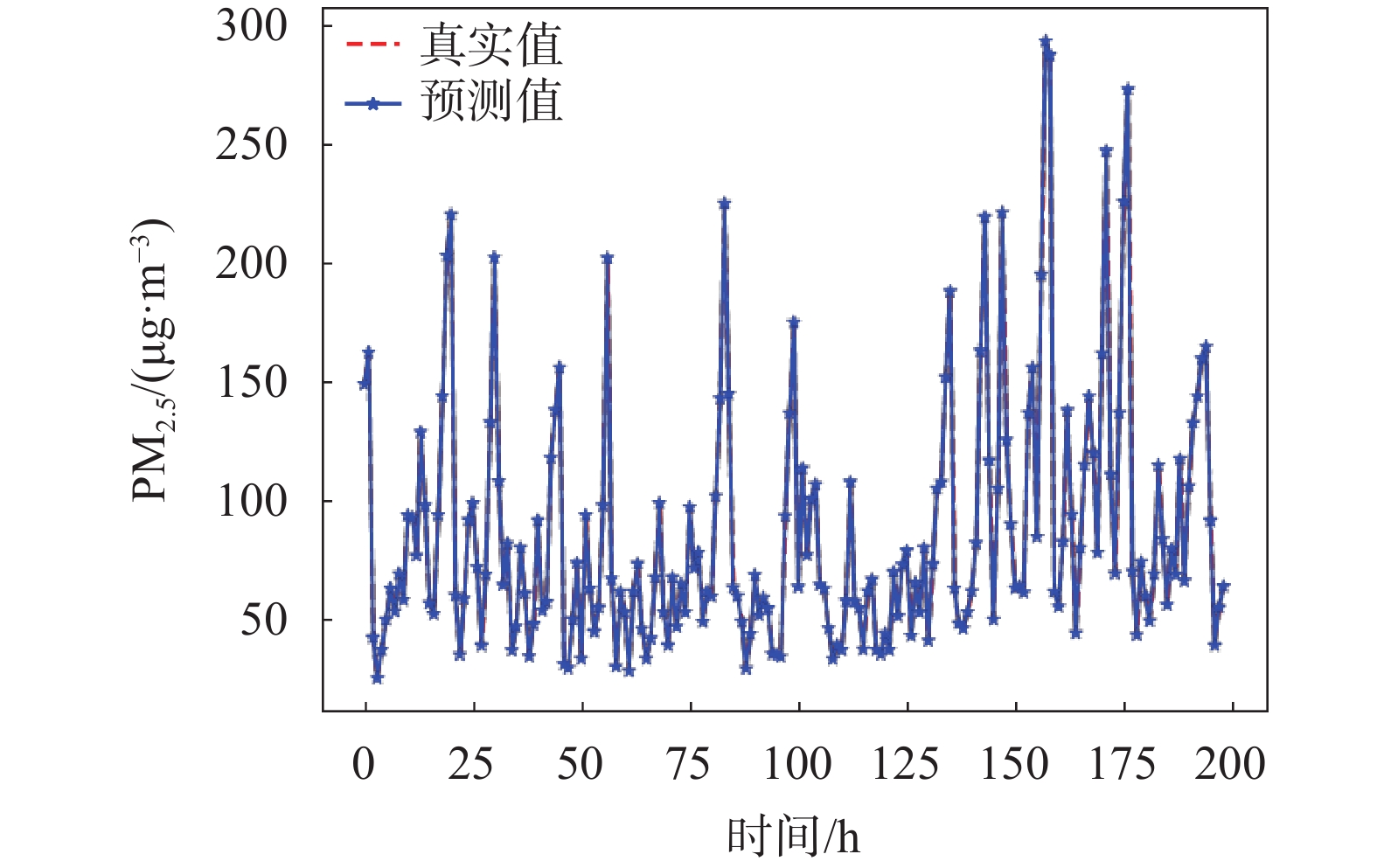

1)为了验证CNN-ILSTM-attention模型预测PM2.5 浓度的准确性,本文引入传统的回归模型(ARIMA、SVR和MLP)作为对比模型。实验结果如图7~图10所示。从图中可以看出,传统的回归模型ARIMA、SVR和MLP的预测拟合度明显低于CNN-ILSTM-attention模型。

|

| 图 7 SVR模型预测值和真实值对比 |

|

| 图 8 MLP模型预测值和真实值对比 |

|

| 图 9 ARIMA模型预测值和真实值对比 |

|

| 图 10 CNN-ILSTM-attention模型预测值和真实值对比 |

表2为4种模型评价指标的对比。从表中可以看出,CNN-ILSTM-attention预测模型的预测效果最好。与SVR模型相比,r2提高了24.9%,RMSE减少了15.04 μg/m3,MAE减少了11.1 μg/m3。与MLP模型相比,r2增加了14.2%,RMSE减少了10.28 μg/m3,MAE减少了9.92 μg/m3。与ARIMA模型相比,CNN-ILSTM-attention模型的r2提高了12.1%,RMSE减少了8.67 μg/m3,MAE减少了7.07 μg/m3。因此,相比较ARIMA、SVR和MLP模型,CNN-ILSTM-attention模型对PM2.5 浓度的预测具有较高的准确性。

| 算法模型 | RMSE/(μg·m–3) | MAE/(μg·m–3) | r2/% |

| SVR | 16.82 | 12.16 | 73.6 |

| MLP | 12.06 | 10.98 | 84.3 |

| ARIMA | 10.45 | 8.13 | 86.4 |

| CNN-ILSTM-attention | 1.78 | 1.06 | 98.5 |

2)为了全面评估所提模型,本文选用基于门控技术的递归神经网络模型(LSTM)以及混合预测模型(CNN-LSTM、CNN-LSTM-attention、CNN-ILSTM)与本文所提模型进行对比。

图11为LSTM、CNN-LSTM、CNN-LSTM-attention、CNN-ILSTM以及CNN-ILSTM-attention5种算法模型预测PM2.5 浓度结果对比图。图12为5种预测模型相对误差对比图。从图中可以发现,PM2.5 实际浓度值在不停地变化,LSTM和CNN-LSTM两种预测模型能大致地捕捉PM2.5 浓度变化规律,但依然存在预测误差较大的问题。CNN-LSTM-attention模型、CNN-ILSTM模型、CNN-ILSTM-attention模型都能够准确捕捉PM2.5 浓度变化规律,但无法准确捕捉到当PM2.5 浓度发生突然变化时的规律。在CNN-ILSTM-attention预测模型中,注意层能够通过输入数据提取和存储在记忆单元中来改善深度学习模型中的记忆性能。从图中可以看出,CNN-ILSTM-attention模型预测效果明显优于LSTM、CNN-LSTM、CNN-LSTM-attention和CNN-ILSTM这4种预测模型,能够更好地捕捉到PM2.5 浓度突然变化规律,从而准确地预测PM2.5 的浓度。

|

| 图 11 各模型预测结果对比 |

|

| 图 12 各模型相对误差对比 |

LSTM、CNN-LSTM、CNN-ILSTM、CNN-LSTM-attention、CNN-ILSTM-attention模型预测效果对比如表3所示。

| 算法模型 | RMSE/(μg·m–3) | MAE/(μg·m–3) | r2/% |

| LSTM | 17.05 | 12.89 | 72.5 |

| CNN-LSTM | 9.37 | 7.68 | 89.3 |

| CNN-LSTM-attention | 6.45 | 5.47 | 90.5 |

| CNN-ILSTM | 4.68 | 3.26 | 92.3 |

| CNN-ILSTM-attention | 1.78 | 1.06 | 98.5 |

从表中可以看出,CNN-ILSTM-attention模型拥有最高的拟合度以及最低的RMSE和MAE。在RMSE和MAE指标上,比LSTM模型和CNN-ILSTM模型降低了15.27 μg/m3、2.9 μg/m3和11.83 μg/m3、2.2 μg/m3。而CNN-ILSTM-attention模型在拟合度r2为98.5%,较LSTM模型和CNN-ILSTM模型分别提高了26%和6.2%。因此可以得出,CNN-ILSTM-attention模型预测效果优于其他4种预测模型,呈现出更高的预测精度。

4 结束语为了提高预测精度,本文提出了一种基于注意力机制的CNN-ILSTM模型来预测地铁站PM2.5 的浓度。卷积层能够提取局部特征,而改进LSTM层能够获取长期依赖关系,注意力机制可以根据过去的时间捕捉不同特征状态的重要程度。实验结果表明,本文所建立的CNN-ILSTM-attention模型能够捕捉局部和全局的依赖关系,相比典型的LSTM模型、CNN-LSTM模型以及CNN-ILSTM模型,具有更高的预测精度和泛化能力。这为精准预测PM2.5 浓度提供理论和方法的支撑,对于未来开发预警系统和调节通风系统以确保通勤者和地铁工作人员的健康具有一定的指导意义。

| [1] |

XI G, LI W D. A graph-based LSTM model for PM2. 5 forecasting[J]. Atmospheric Pollution Research, 2021 (12): 101150.

|

| [2] |

杨国亮, 余华声, 黄聪. 基于优化组合模型的PM2.5浓度预测[J].

计算机工程与设计, 2023, 44(10): 3132-3137.

YANG G L, YU H S , HUANG C. Prediction of PM2.5 concentration based on optimized combination model[J].

Computer Engineering and Design, 2023, 44(10): 3132-3137.

|

| [3] |

邢红涛, 郭江龙, 刘书安, 等. 基于CNN-LSTM混合神经网络模型的NOx排放预测[J].

电子测量技术, 2022, 45(2): 98-103.

XING H T, GUO J L, LIU S A, et al. NOx emission prediction based on CNN-LSTM hybrid neural network model[J].

Electronic Measurement Technology, 2022, 45(2): 98-103.

|

| [4] |

LOY-BENITEZ J, VILELA P, LI Q, et al. Sequential prediction of quantitative health risk assessment for the fine particulate matter in an underground facility using deep recurrent neural networks[J]. Ecotoxicology and Environmental Safety, 2019(169): 316-324.

|

| [5] |

NOURI A, MEHDI G L. Prediction of PM2. 5 concentrations using principal component analysis and artificial neural network techniques: A case study: Urmia, Iran[J]. Environmental Engineering Science, 2021 (38): 89-98.

|

| [6] |

LI M. Prediction of PM2. 5 concentration based on the similarity in air quality monitoring network[J]. Building and Environment, 2018(137): 11-17.

|

| [7] |

刘拥民, 罗皓懿, 谢铁强. 基于XGBoost-ARIMA方法的PM2.5质量浓度预测模型的研究及应用[J]. 安全与环境学报, 2023, 23 (1): 211-221.

LIU Y M, LUO H Y, XIE T Q. Research and application of PM2.5 mass concentration prediction model based on XGBoost ARIMA method [J]. Journal of Safety and Environment, 2023, 23 (1): 211-221.

|

| [8] |

FENG R. Recurrent neural network and random forest for analysis and accurate forecast of atmospheric pollutants[J]. Journal of Cleaner Production, 2019 (231): 1005-1015.

|

| [9] |

于伸庭, 刘萍. 基于长短期记忆网络-卷积神经网络(LSTM-CNN)的北京市PM2.5浓度预测[J].

环境工程, 2020, 38(6): 176-180.

YU S T, LIU P. Prediction of PM2.5 concentration in Beijing based on long short termmemory network convolutional neural network (LSTM-CNN)[J].

Environmental Engineering, 2020, 38(6): 176-180.

|

| [10] |

ONG B, KOJI Zl. Dynamically pre-trained deep recurrent neural networks using environmental monitoring data for predicting PM2. 5[J]. Neural Computing and Applications, 2016(27): 1553-1566.

|

| [11] |

朱菊香, 谷卫, 罗丹悦, 等. 基于PSO优化BP神经网络的多传感器数据融合[J].

中国测试, 2022, 48(8): 94-100.

ZHU J X, GU W, LUO D Y, et al. Multi sensor data fusion based on PSO optimized BP neural network[J].

China Measurment & Test, 2022, 48(8): 94-100.

|

| [12] |

ALBIRMIZY S, BANAZ Q. Multivariate time series forecasting with lstm for madrid, spain pollution[C]//2019 International Conference on Computing and Information Science and Technology and Their Applications (ICCISTA), 2019.

|

| [13] |

ABIRAMI S. Hybrid spatio-temporal deep learning framework for particulate matter (PM2.5) concentration forecasting[C]//2020 International Conference on Innovative Trends in Information Technology (ICITIIT), 2020.

|

| [14] |

白盛楠, 申晓留. 基于LSTM循环神经网络的PM2.5预测[J].

计算机应用与软件, 2019, 36(1): 67-70.

BAI S N, SHEN X L. PM2.5 prediction based on LSTM recurrent neural network[J].

Computer Applications and Software, 2019, 36(1): 67-70.

DOI:10.3969/j.issn.1000-386x.2019.01.012 |

| [15] |

赵彦明. 基于时空相关性的LSTM算法及PM2.5浓度预测应用 [J]. 计算机应用与软件, 2021, 38 (6): 249-255.

ZHAO Y M. LSTM algorithm based on spatiotemporal correlation and its application in predicting PM2.5 concentration [J]. Computer Applications and Software, 2021, 38 (6): 249-255.

|

2024, Vol. 50

2024, Vol. 50